¶ KI Modelle

¶ K-Nächste-Nachbarn (K-nearest-neighbors (KNN))

- die k nächsten Nachbarn, aus den Trainingsdaten, eines unbekannten Datenpunktes werden angesehen um den Wert des Datenpunktes zu bestimmen

- Bei Klassifizierung: Mehrheit der Labels der k-Nachbarn bestimmt Label des Datenpunktes

- Bei Regression: Mittelwert der k-Nachbarn wird gefunden und bestimmt Wert des Datenpunktes

- Muss nicht Trainiert werden, benötigt aber dennoch Trainingsdaten um die Nachbarn neuer Datenpunkte zu finden

- Durch k entsteht eine "Decision Boundary", die bestimmt wie genau die Vorhersage ist

| Vorteile | Nachteile |

|---|---|

| Keine Trainingszeit | Braucht lange für Vorhersagen |

| Einfache und Verständliche Ergebnisse | Erkennt nur einfache (lineare) Beziehungen |

| Hat nur einen nicht vom Modell festgelegten Parameter (Hyperparameter), k --> einfach zu optimieren | Eignet sich nicht zur Vorhersage von noch passierenden Ereignissen (Zukunftsvorhersagen) Bsp: Regnet es morgen? |

¶ Entscheidungsbäume

¶ Was ist ein Entscheidungsbaum?

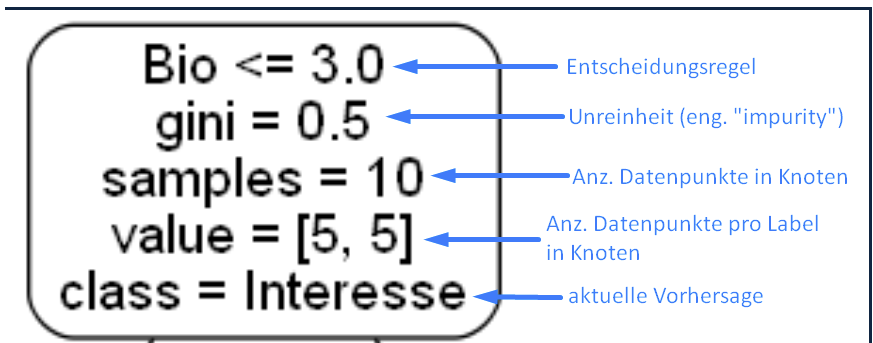

Ein Entscheidungsbaum besteht aus mehreren Knoten. Hierbei wird zwischen Entscheidungsknoten, die Zwischenergebnisse beinhalten, und Blattknoten, die keine weiteren Verzweigungen mehr besitzen und an denen wir das Endergebnis ablesen können unterschieden. Verbunden werden diese Knoten durch Äste, welche die möglichen Antworten auf die Knoten bestimmen.

- Impurity (Unreinheit) gibt an wie viele Datenpunkte falsch zugeordnet werden.

- Der optimale Entscheidungsbaum hat möglichst reine Knoten (keine Falsch zugeordneten Datenpunkte) und ist möglichst klein.

- Die Decision Boundary, die durch einen Entscheidungsbaum resultiert, besteht immer aus geraden Linien. Je mehr Entscheidungsknoten der Baum besitzt, desto mehr Linien kommen hinzu.

- Ein Entscheidungsbaum kann für Regression (Vorhersage einer Zahl) und Klassifikation (Bestimmung einer Klasse) verwendet werden

¶ Neuronale Netze

Gute Zusammenfassung: https://www.youtube.com/watch?v=1fQrOek4buQ

Neuronale Netze

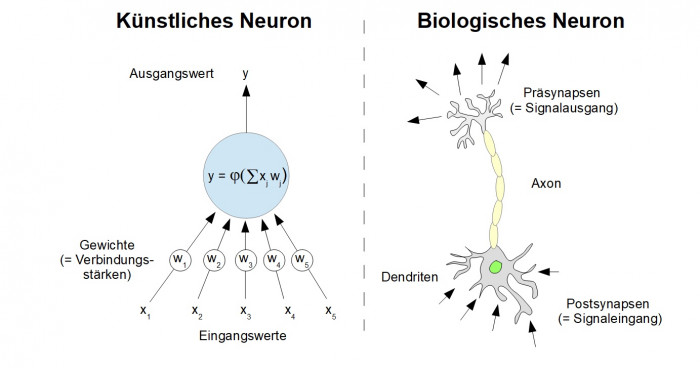

Ein von biologischen Gehirnen inspiriertes Modell mit vernetzten künstlichen Neuronen, das durch Trainingsdaten Muster erkennt und komplexe Zusammenhänge lernt.

Ein Neuron bekommt Eingabewerte x übergeben. Diese werden mit Gewichten w multipliziert. Jedes Neuron bildet die Summe () dieser gewichteten Eingaben und berechnet den Wert einer Aktivierungsfunktion ().

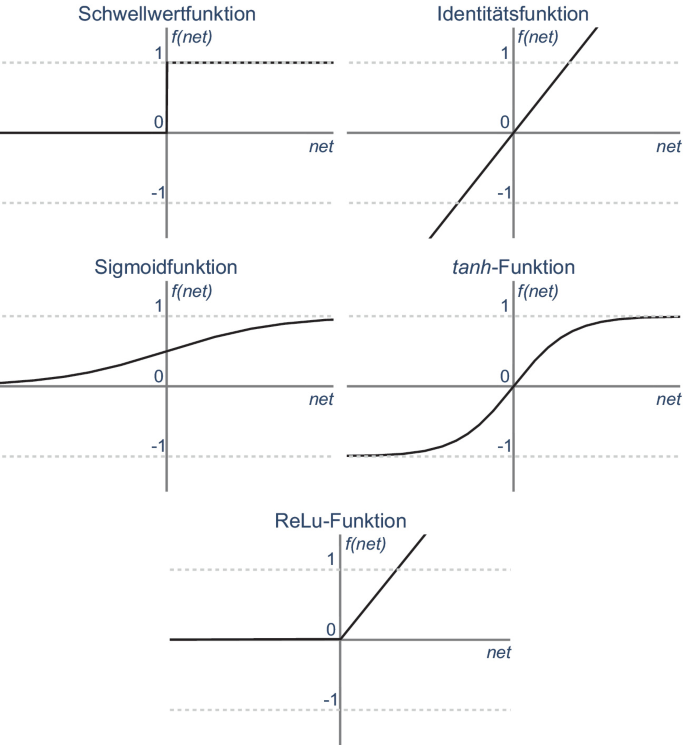

Typische Aktivierungsfunktionen:

Ein künstliches neuronales Netz kombiniert viele Neuronen. Diese werden in Schichten organisiert.

![]()

¶ Lernen

Die Gewichte in einem künstlichen neuronalen Netz sind nach der Erstellung zufällig. Damit sind die Entscheidungen des Netzes zufällig. Hier kommt der Lernalgorithmus ins Spiel. Er berechnet für die Trainingsdaten die größe des Fehlers und passt danach von der Ausgabeschicht rückwärts die Gewichte an. Deshalb heißt er auch Backpropagation-Algorithmus. Sein Ziel ist die Minimierung des Fehlers für die Trainingsdaten. Dies geschieht mathematisch durch finde des Minimus der Fehlerfunktion durch Gradientenabstieg.

Visualisierung des Gradientenabstiegs. Die Schrittweite wird durch die Lernrate bestimmt.

¶ Beispiele und Spielwiesen

- Erkennung von Ziffern (MNIST): https://www.hartundtrocken.de/my-product/interaktiv-neuronales-netz/

- Klassifizierung von Punkten: https://playground.tensorflow.org/